Содержание

- Введение

- Четвертое поколение Tegra

- Графические возможности и игровое применение

- Коммуникационные возможности

- Предварительная оценка производительности и энергопотребления

- Вычислительная фотография

- Портативная игровая консоль Shield

- Выводы

Введение

Несколько лет назад NVIDIA начала проектирование систем-на-чипе, оценив растущую важность мобильных устройств в ближайшем будущем. Первая система-на-чипе NVIDIA была анонсирована еще в 2008 году, это была Tegra APX 2500, не добившаяся особенного успеха. Затем появилась линейка Tegra 6xx и модель APX 2600. Чипы APX предназначались для смартфонов, а вот Tegra 6xx — для смартбуков и так называемых MID-устройств. Первое поколение Tegra оказалось не слишком удачным, эти чипы применялись разве что в Microsoft Zune HD и Samsung M1.

Но NVIDIA не сдавалась, и в 2010 году было объявлено новое поколение Tegra 250 (Tegra 2), а в 2011-м последовало и третье поколение — четырехъядерное решение Tegra 3 (также известное под кодовым именем Kal-El). Постепенно системы-на-чипе NVIDIA улучшались, становясь все привлекательнее, особенно для планшетов и смартбуков, так как они обеспечивали достаточно высокую производительность.

Третье поколение системы-на-чипе у NVIDIA действительно получилось неплохим, оно включало не только четыре ядра Cortex-A9, но и пятое ядро-компаньон, работающее в режимах малой нагрузки на CPU и экономящее энергию. Плюс, по сравнению с Tegra 2, обеспечивалась поддержка SIMD-команд NEON, а GPU нового чипа был ускорен в несколько раз. Немудрено, что применение SoC NVIDIA расширялось — на базе Tegra 3 вышло большое количество устройств, в основном планшетов.

Компания явно не собиралась останавливаться на достигнутом, и еще в 2011 году на Mobile World Congress NVIDIA объявила, что новые Tegra будут выпускаться каждый год — следующей как раз должна была стать система под кодовым именем Kal-El. Еще через год планировалось решение под кодовым именем Wayne, затем — Logan, и в 2014-м — Stark (все кодовые имена — имена супергероев из комиксов).

Таким образом, изначально выход Wayne планировался к запуску Windows 8 во второй половине 2012 года, но его пришлось отложить на 2013-й — несмотря на обещание обновлять семейство ежегодно. Судя по всему, сама NVIDIA была готова к запуску и в конце 2012 года, но им пришлось подождать партнеров, которые планировали анонсировать конечные продукты на CES 2013.

Уже пару лет назад было понятно, что главным достоинством нового чипа NVIDIA Tegra 4 будет технологический процесс 28 нм, который позволит значительно улучшить энергоэффективность. И целью для Wayne был уровень энергопотребления, не превышающий показателей Kal-El при большей производительности. Впрочем, вероятно разделение линейки Tegra 4 на несколько моделей, наиболее быстрые из которых будут предназначены для мощных устройств и будут отличаться высоким потреблением энергии вместе с впечатляющей производительностью.

В декабре 2012-го китайские источники выложили слайд, позволяющий узнать базовые характеристики Tegra 4: поддержка технологии 4-Plus-1 (четыре высокопроизводительных CPU-ядра + одно энергоэффективное), вычислительная архитектура Cortex-A15, 72 шейдерных процессора GeForce (в 6 раз мощнее Tegra 3), двухканальный контроллер оперативной памяти DDR3L/LPDDR2/LPDDR3, поддержка USB 3.0, декодирование и кодирование видеороликов в разрешении 1440p, поддержка дисплеев с разрешением до 2560×1600, мощный процессор обработки изображений и др.

Примерно тогда же стало понятно, что новый чип NVIDIA будет представлен в 2013 году — или на выставке CES 2013, или на февральской MWC 2013. Похоже, что NVIDIA решила разделить анонс Tegra 4 — сам чип был анонсирован перед CES, а подробные технические детали публике расскажут позже (возможно, как раз на MWC или на собственном мероприятии).

Четвертое поколение Tegra

В каждом из поколений своих мобильных чипов NVIDIA старалась выступать на самом высоком уровне, выпуская лидирующие по скорости решения на момент их выхода. Но со времени анонса Tegra 3 прошло довольно много времени, и этот чип уже не является самой мощной SoC на рынке. Конкуренты уже выпустили двухъядерные чипы Cortex-A15 (Samsung) и четырехъядерные Krait (Qualcomm), и явно настало время для обновления мобильной линейки NVIDIA. И вот, на специальном мероприятии перед выставкой CES была объявлена очередная версия этого чипа — Tegra 4.

Новый чип предназначен для использования в широком спектре устройств: смартфонах, планшетах, игровых устройствах, автомобильных информационных и навигационных системах и т. д. NVIDIA называет эту мобильную систему-на-чипе «быстрейшим в мире мобильным процессором». Слухи о спецификациях новой SoC, известной ранее под кодовым именем Wayne, оказались верными — действительно, в полном соответствии с «утекшим» в декабре слайдом, новое решение включает четыре ядра Cortex-A15 с дополнительным энергоэффективным ядром-компаньоном и графическое ядро GeForce, состоящее из 72 ядер.

Среди других особенностей новой системы можно выделить еще и модемную часть с поддержкой мобильных сетей четвертого поколения (4G LTE). Впрочем, последнее относится не к самому кристаллу Tegra 4: поддержка мобильных сетей в решениях NVIDIA все так же возложена на отдельный чип. Таким образом, все системы на базе Tegra 4, требующие поддержки мобильных сетей, будут комплектоваться вторым чипом — модемом 4G LTE собственного дизайна NVIDIA:

Что еще видно из этого слайда? Во-первых, никуда не делось пятое ядро — оно нам известно еще по Tegra 3. Во-вторых, схематический снимок чипа модемной части выглядит довольно любопытно — это разработка Icera, которая имеет интересные особенности, которые мы подробно разберем ниже.

Как мы уже знаем, дополнительное CPU-ядро нужно, чтобы повысить энергоэффективность мобильной системы-на-чипе. Мы подробно разбирали это решение в предварительном обзоре Tegra 3 — тогда эта архитектура называлась vSMP, но затем ей дали маркетинговое название 4-Plus-1. Пятое ядро-компаньон работает в режимах малой нагрузки, то есть бо́льшую часть времени для мобильных устройств (режим простоя или чтения, просмотра видео, телефонных звонков, даже несложного веб-серфинга — это все малая нагрузка, с которой вполне справится одно ядро), а основные четыре ядра Tegra в это время отключаются вовсе, почти не потребляя энергии.

При этом вспомогательное ядро Tegra 4 также имеет архитектуру Cortex-A15, как и основные ядра, но оно оптимизировано для работы на более низких частотах и напряжении. Технология 4-Plus-1 отличается от сравнимой в общих чертах технологии big.LITTLE компании ARM, которая будет использоваться в будущих системах-на-чипе Samsung. Хотя общая концепция этих решений аналогична, и NVIDIA была первой, кто ее внедрил (возможно, даже вынужденно, так как Tegra 3 нельзя назвать сверхэкономичной SoC), но в деталях они во многом отличаются, как аппаратно, так и с точки зрения программной поддержки. Вспомогательное низкопотребляющее ядро у Tegra 4 работает «прозрачно» для операционной системы и приложений, как и в случае Tegra 3, и этим оба чипа NVIDIA отличаются от архитектуры big.LITTLE.

С аппаратной точки зрения это даже более интересное решение, но, к сожалению, на практике оно означает, что в той же Windows RT пятое ядро использоваться не будет, и в таких устройствах по энергоэффективности из Tegra 4 явно не выжмут максимум возможного. А представители компании Qualcomm вообще утверждают, что их решения не нуждаются во вспомогательном ядре для экономии энергии, так как вычислительные ядра в их чипах способны работать каждое на своей частоте и с собственным напряжением. Чей подход правильнее? Ответить на этот вопрос могут только тесты энергоэффективности, все технологии интересны по-своему.

Что касается аппаратных нововведений Tegra 4, то еще одной важной особенностью является поддержка памяти. В предварительном обзоре Tegra 3 мы сетовали, что эта SoC имеет лишь один канал доступа к оперативной памяти, что может являться ограничителем производительности в некоторых случаях. Уже тогда некоторые из конкурентов NVIDIA предлагали мобильные чипы с двухканальным доступом к памяти, что являлось их преимуществом. Можно вздохнуть спокойно — в Tegra 4 этот потенциальный недостаток был устранен, новая система-на-чипе поддерживает двухканальный интерфейс памяти стандартов LP-DDR2 и LP-DDR3.

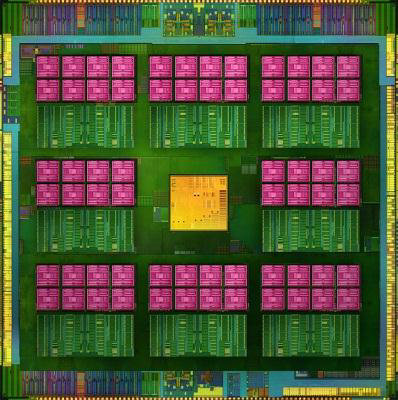

Площадь кристалла у Tegra 4 лишь чуть больше, чем у Tegra 3 (порядка 80 мм²), что стало возможным благодаря применению современного техпроцесса 28 нм. Система-на-чипе Tegra 4 производится на заводах тайваньской компании TSMC с использованием 28-нанометрового техпроцесса «HPL», в котором применяется технология производства High-K и транзисторы с металлическим затвором (Metal Gate). У TSMC есть несколько видов техпроцесса 28 нм, и вполне возможно, что «HPM» для мобильного чипа подошел бы еще лучше, так как «HPL» оптимизирован для низких утечек, а «HPM» — для достижения высоких частот. Видимо, в том числе поэтому максимальная частота основных вычислительных ядер Tegra 4 ограничена пределом 1,9—2,0 ГГц, хотя конкуренты уже анонсировали решения, работающие на 2,0—2,5 ГГц. Но инженерам NVIDIA виднее…

Интересно, что четвертое поколение Tegra технологически отличается от чипов Tegra 3 и Tegra 2, которые производились по высокопроизводительному техпроцессу «G» и части кристаллов которых имели участки, произведенные по оптимизированному для низких утечек техпроцессу «LP» (об этом подробно написано в предварительном обзоре Tegra 3) — в данном случае такой особенности нет.

Графические возможности и игровое применение

В предварительном обзоре Tegra 3 мы предположили, что в Wayne будут использоваться не только вычислительные ядра Cortex-A15, но и совершенно новое графическое ядро, в отличие от трех предыдущих поколений Tegra, использовавших одну и ту же графическую архитектуру. К сожалению, несмотря на все уверения о совершенно новом GPU, на первый взгляд он больше похож на улучшенное видеоядро, известное нам по предыдущим мобильным чипам NVIDIA.

GPU в Tegra 4 все так же не унифицированный, пиксельные и вершинные шейдеры выполняются разными исполнительными блоками, а точность пиксельных расчетов лишь 20-битная, то есть до возможностей конкурирующих чипов, поддерживающих OpenGL ES 3.0 и OpenCL, этот GPU все же не дотягивает. Хотя видеоядро Tegra 4 и поддерживает неграфические вычисления, но только при помощи шейдерного языка GLSL из Open GL ES — это применяется для задач вычислительной фотографии, о которой будет рассказано дальше. К сожалению, OpenCL и CUDA новым чипом не поддерживаются, и появление такой функциональности ожидается лишь в следующих поколениях Tegra.

Судя по предварительным данным, похоже на то, что в NVIDIA решили лишь увеличить в несколько раз количество исполнительных блоков в GPU, а также сделать некоторые аппаратные модификации вроде поддержки мультисэмплинга (MSAA) и одновременного рендеринга в несколько буферов (MRT). В общем-то, от мобильных GPU сейчас и не нужно что-либо большее, так как все ограничивается средним уровнем возможностей (а даже у наиболее распространенных устройств Apple они не превышают то, что умеет Tegra 4), но именно от NVIDIA всегда ожидается нечто большее. Тем более, что они не первый год обещают серьезно улучшить возможности мобильной графики в своих будущих решениях. Что ж, будем ждать полноценного обновления графического ядра — а вдруг ждать осталось не так уж и долго?

Зато с точки зрения программной поддержки у Tegra всегда все прекрасно. NVIDIA начала наступление на рынок мобильных систем-на-чипе, предназначенных для игр, выпустив специальное приложение TegraZone, предназначенное для установки 3D-игр, специально оптимизированных для Tegra и отличающихся от обычных Android-версий дополнительными эффектами. Этот специализированный магазин 3D-приложений получил довольно широкое распространение и был загружен пользователями уже более 6 миллионов раз.

TegraZone — серьезное преимущество решений NVIDIA, так как пользователь смартфона или планшета на базе любого из чипов Tegra без всяких проблем может получить игры и другие 3D-приложения, специально оптимизированные и улучшенные для его устройства. Совместная работа с игровыми разработчиками — это то, в чем NVIDIA хороша, и в настольных решениях, и в мобильных. И в TegraZone собраны действительно одни из лучших мобильных игр.

Инициатива TegraZone — это не только дополнительные эффекты в играх, предназначенные специально для устройств на базе Tegra. NVIDIA старается перенести в мобильные решения свой подход на рынке настольных ПК, тестируя различное ПО на устройствах на базе своих чипов с разными операционными системами, а также помогая разработчикам выпускать их игровые проекты на рынок.

На презентации в Лас-Вегасе NVIDIA показала новую игру в жанре стрелялки от первого лица (FPS), оптимизированную для Tegra 4 — проект под названием Dead Trigger 2. Конечно, мобильная графика уступает настольной, но ее уровень явно приближается к тому, что показывает нынешнее поколение настольных консолей — по крайней мере в играх, которые появлялись в первые годы их рыночной жизни.

На данный момент в TegraZone доступны 63 игры, и более 40 числятся в разработке. Конечно, далеко не все из них оптимизированы именно для Tegra 4, но и таких уже достаточно много — 12 штук, и список продолжит пополняться. Среди уже оптимизированных можно отметить следующие проекты: ARMA Tactics, Bloodsword, Burn Zombie Burn, Codex the Warrior, Dead Trigger 2, Real Boxing, Riptide 2, Rochard, RU Golf, Space Ark, Vampire Hunter и Zombie Driver.

Коммуникационные возможности

Как мы уже писали в наших предыдущих материалах по Tegra, примерно полтора года назад NVIDIA купила компанию Icera, специализирующуюся на проектировании коммуникационных решений для мобильных устройств, которые отличаются тем, что не имеют жесткой аппаратной реализации, а являются полностью программируемыми — так называемые software defined radio (SDR). И сейчас настало время, когда NVIDIA начала выпуск своего первого коммуникационного чипа Icera — i500. Он поддерживает сети LTE, причем по всему миру, а не только в каких-то определенных странах, как это бывает у некоторых мобильных решений.

В состав коммуникационного чипа NVIDIA входит восемь программируемых процессоров, которые выполняют все необходимые вычисления для работы в сетях 3G и 4G. Каждый из этих восьми процессоров обладает производительностью 160 млрд операций (узкоспециализированных, естественно) в секунду, то есть более 1,2 трлн операций в секунду в целом. Это примерно вчетверо бо́льшая производительность по сравнению с предшествующей моделью чипа.

NVIDIA утверждает, что архитектура SDR позволяет загружать в чип и использовать специальные профили для стран и городов с разными мобильными сетями и за счет этого получать преимущество в эффективности. Они считают, что применение программируемого модема Icera выгоднее обычных модемов с поддержкой LTE, используемых другими производителями. В случае с обычными модемами поддержка сетей 3G, 4G и т. д. обеспечивается выделенными блоками, и некоторые их части дублируются в разных областях чипа, а программируемый чип Icera способен использовать свои восемь программируемых процессоров при работе с любым стандартом беспроводных сетей. По данным NVIDIA, их решение эффективнее и примерно на 40% меньше обычных модемных чипов по площади.

Чипы Icera i500 также производятся на фабрике TSMC, но по высокопроизводительному 28-нанометровому техпроцессу «HP» с применением High-K и транзисторов Metal Gate. Казалось бы, внешний чип — это недостаток, но NVIDIA видит плюс применения внешнего LTE-чипа в том, что в производительном режиме «HP»-ядро потребляет меньше энергии, а в режиме простоя можно будет отключить модемный чип вовсе.

Кроме того, в i500 есть возможность отключения (power gate) каждого из восьми ядер в зависимости от загрузки и необходимости. Программный модем Icera i500 изначально выйдет с поддержкой LTE-сетей Category 3 (100 Мбит/с), но позднее он будет обновлен до Category 4 (150 Мбит/с), за что можно поблагодарить возможность обновления программного модема архитектуры SDR без необходимости внесения аппаратных модификаций.

Чип Icera i500 пройдет всю необходимую сертификацию для работы с мобильными сетями к моменту выхода первых устройств на рынок, а вот первый интегрированный в SoC модем NVIDIA планирует выпустить в составе уже другой системы-на-чипе, известной под кодовым названием Grey, которая будет анонсирована и выйдет на рынок в этом году несколько позднее.

Предварительная оценка производительности и энергопотребления

Честно говоря, нам мало что известно о производительности нового решения NVIDIA. Сама компания уверена, что именно Tegra 4 обеспечивает «лучший пользовательский опыт» при работе в интернете, с мультимедиа и в играх по сравнению со всеми конкурентами. Было бы странно, если бы они заявили обратное.

По данным NVIDIA, четыре ядра Cortex-A15 обеспечивают в среднем 2,6-кратный прирост в распространенных приложениях по сравнению с предыдущей версией чипа — Tegra 3. Также в новой SoC 4 содержится 72 ядра графического процессора GeForce — в шесть раз больше, чем в Tegra 3. Но это лишь теоретические цифры. В случае с мобильными чипами вообще непонятно: какая производительность достаточна для смартфона? В каких приложениях планшету не хватает скорости и плавности? Все основные повседневные задачи и на текущих мобильных устройствах выполняются достаточно быстро — все прекрасно работает и так.

Но ведь существуют задачи, которые ранее были просто недоступны на карманных устройствах именно из-за недостатка их мощности. Кроме того, даже в тех задачах, которые выполняются достаточно быстро, можно достичь еще большей плавности и комфортности. Например, банальный веб-серфинг. При посещении веб-страниц, насыщенных сложной графикой, множеством скриптов и анимаций, иногда возникают «тормоза» даже на устройствах самого высокого уровня.

Другое дело, что измерить эту разницу и показать ее наглядно очень непросто. NVIDIA выбрала такой метод: они сравнили скорость последовательного открытия 25 веб-страниц на двух планшетах: собственном устройстве (видимо, референсном планшете NVIDIA) на базе Tegra 4 и Google Nexus 10, основанном на чипе Samsung Exynos 5 Dual (ранее известном как Exynos 5250), имеющем лишь два ядра Cortex-A15, работающие на частоте 1,7 ГГц.

Время открытия массива из 25 веб-страниц со сложным контентом на Nexus 10 составило 50 секунд — и лишь 27 секунд на планшете с Tegra 4. Все бы хорошо, но только NVIDIA почему-то выполнила это сравнение, используя разные браузеры на мобильных решениях: Chrome для Nexus 10 и стандартный браузер Android в случае с референсным устройством на базе Tegra 4. Судя по многочисленным тестам, Chrome в тестах веб-производительности оказывается несколько медленнее, а значит, и смысла в подобном неравном сражении не очень много. Тем не менее, приведем сравнение Tegra 4 и с другими устройствами по версии NVIDIA:

Нужно отметить, что хотя пользователь нечасто загружает по 25 страниц за один раз, разницу между открытием фейсбука или iXBT.com за 1 или 2 секунды он заметить вполне в состоянии, и такое улучшение в виде ускорения открытия сайтов можно только приветствовать. Как видно по диаграмме NVIDIA, их Tegra 4 справляется с этой задачей быстрее всех существующих на данный момент устройств, включая и быстрейшее из них — Apple iPad 4.

Мы сейчас говорили о скорости CPU-части, а про GPU известно еще меньше — даже теоретических тестов публично еще никто не показывал. Известно, что 72-ядерный GeForce GPU разработан специально для мобильной системы-на-чипе Tegra 4 и включает многочисленные разработки из настольных поколений графических процессоров компании, в том числе из Kepler. Но о производительности GPU-ядра можно пока судить лишь по очень примерным оценкам NVIDIA — они полагают, что Tegra 4 в теории до шести раз быстрее, чем Tegra 3.

Шестикратный рост производительности графического ядра по сравнению с Tegra 3 обосновывается тем, что Tegra 4 имеет в 6 раз больше шейдерных ядер (72 против 12 штук), а также включает некоторые аппаратные оптимизации в конвейере и подсистеме кэширования данных. Естественно, что в реальных игровых применениях разница будет меньшей, так как прямой зависимости от мощности шейдерных блоков тут просто нет, да и ограничителей скорости рендеринга много: эффективность игрового кода или драйвера, упор в CPU или пропускную способность памяти и т. п. Но в среднем, по ожиданиям компании, у Tegra 4 должно получиться 3-4-кратное ускорение в общепризнанных тестах графической производительности по сравнению с SoC предыдущего поколения.

Такой рост производительности 3D-вычислений нужен для того, чтобы обеспечить комфортную частоту кадров на устройствах с дисплеями высокого разрешения (от 1920×1080 до 2560×1440), которые уже начали выходить. Также мощность GPU вполне востребована в задачах вычислительной фотографии, распознавании речи и образов, а также других вычислительно-интенсивных алгоритмах, в которых можно задействовать GPU. Не говоря уже о будущих 3D-играх, в которых можно будет использовать более сложную геометрию и попиксельную обработку для получения реалистичной картинки.

Похоже, что SoC у NVIDIA получилась достаточно мощной. Но как это скажется на времени автономной работы — ведь между этими параметрами обратная зависимость? Компания уверяет, что Tegra 4, имеющая CPU-ядра Cortex-A15, потребляет значительно меньше энергии при выполнении одной и той же вычислительной работы по сравнению с Tegra 3, основанной на таком же количестве ядер Cortex-A9. И в это вполне можно поверить, ведь разница в одних только техпроцессах их производства огромна.

Повторим, что, как и в случае предыдущего решения, в состав Tegra 4 входит пятое ядро, аналогичное четырем основным (тоже Cortex-A15 в данном случае), но более экономичное. Таким образом, это уже второе поколение энергоэффективной архитектуры 4-Plus-1, о которой мы писали в предварительном обзоре Tegra 3 (тогда она еще называлась vSMP), но о каких-либо положительных изменениях в нем пока что неизвестно. Вероятно, Tegra 4 все же имеет некие улучшения, связанные с управлением питанием, напряжением и частотой отдельных блоков.

В разделе энергопотребления и эффективности можно отметить еще и технологию модуляции яркости дисплея PRISM 2, позволяющую снизить расходы энергии на подсветку экрана — она обеспечивает экономию энергии на четверть больше, чем первое поколение PRISM. Все вместе в типичных применениях, по данным NVIDIA, дает до 45% экономии энергии по сравнению с Tegra 3. Также обещается, что применение Tegra 4 в мобильных телефонах должно обеспечить порядка 14 часов проигрывания видео высокого разрешения.

Вычислительная фотография

Кроме уже привычных применений для мобильных устройств, есть и другие интересные приложения для смартфонов и планшетов, требующие высокой вычислительной мощности. Например, вычислительная фотография, для которой NVIDIA применяет программно-аппаратное решение, названное Computation Photography Engine. В последние годы фотография сильно изменилась, и индустрия почти полностью отошла от аналоговых пленочных камер к решениям на основе цифровых сенсоров. Используется все меньше и меньше пленки, и продолжаются исследования на тему того, что еще можно сделать с информацией, получаемой с цифровых чувствительных элементов. Список новых технологий весьма широк — от определения улыбок и моргания глаз в бытовых камерах до воссоздания объемных объектов в трех измерениях по нескольким двумерным фотографиям. Все это можно назвать вычислительной фотографией.

Вычислительная фотография объединяет техники захвата и обработки изображений, служащие для расширения возможностей цифровой фотографии. Чаще всего в вычислительной фотографии обрабатывается по нескольку кадров, и в качестве наиболее простых примеров можно привести съемки панорам (современные смартфоны уже умеют делать их автоматически), фотоснимки в расширенном динамическом диапазоне (HDR) или пленоптические камеры вроде Lytro, а также применение в системах компьютерного зрения. Напомним, пленоптические камеры (камеры светового поля) используют массив микролинз для получения информации о световом поле сцены в четырех измерениях, и их особенностью является возможность настраивать точку фокусировки уже после того, как сделан снимок.

Одним из наиболее интересных уже реализованных примеров вычислительной фотографии можно назвать съемку в расширенном динамическом диапазоне (HDR). Это крайне важно для мобильных устройств, ведь у сенсоров, применяемых в их фотомодулях, динамический диапазон весьма невелик — они не могут одновременно захватить и темные области, и сильно освещенные:

Эффект нехватки динамического диапазона знаком всем, кто когда-либо снимал фотоаппаратом: в летний солнечный день довольно сложно сфотографировать так, чтобы и небо не было высветлено в сплошной белый цвет, и детали в тенях не потерялись (см. пример выше). Для того чтобы запечатлеть визуальную информацию так, как ее способен видеть человек, применяются специальные методы, вроде расширения динамического диапазона.

Принцип HDR-фотосъемки заключается в одновременном снятии нескольких кадров с разной экспозицией (сочетанием выдержки и диафрагмы) и объединении их по определенным алгоритмам, помогающим отобразить максимум информации. Чаще всего делается два снимка с разной экспозицией: первый нужен для того, чтобы запечатлеть детали в сильно освещенной части, а второй — в тенях. Но при последовательном снятии двух кадров это подходит разве что для фотографирования неподвижных объектов или постановочной фотосъемки. В случае же репортажной съемки текущие возможности HDR-фотосъемки приводят к таким артефактам:

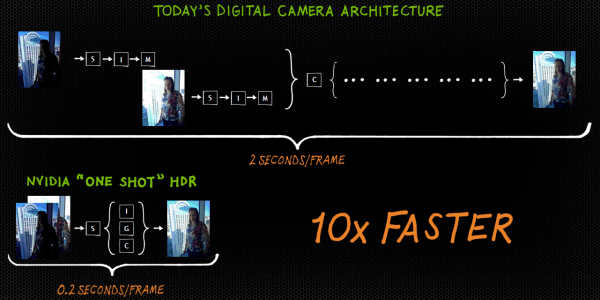

Природа артефакта понятна — ведь объединяются два кадра, сделанные не одновременно. И процесс HDR-съемки — одно из тех применений, которые можно улучшить, радикально ускорив время обработки. Но чем отличается подход NVIDIA от того, что делается в нынешних устройствах? На данный момент обработкой фотографий занимается специальный сопроцессор обработки сигналов (ISP), который считывает информацию с сенсора и только после обработки записывает в память для дальнейших вычислений на CPU.

NVIDIA Computation Photography Engine отличается тем, что способен одновременно обеспечивать доступ к данным с сенсора для всех ядер CPU и GPU, а также для сопроцессора по обработке изображений ISP, чтобы значительно ускорить обработку снимков, в том числе и при фотосъемке в расширенном динамическом диапазоне. Причем в случае с Tegra 4 два снимка с разной экспозицией делаются одновременно (см. две стрелочки, направленные в сенсор).

Все это значительно ускоряет сложную обработку кадров, которая подразумевается вычислительной фотографией. Параллельная съемка и обработка двух изображений сокращает время в разы. В качестве примера ускорения приводится сравнение с HDR-съемкой на Apple iPhone 5. Если в случае с нынешними телефонами Apple им нужно 1,5-2 секунды на кадр в расширенном динамическом диапазоне, то Tegra 4 делает HDR-кадр за 0,2 секунды.

В результате любая фотография может быть сделана в расширенном динамическом диапазоне, и даже более того — возможна запись HDR-видео! На презентации Tegra 4 был показан прототип планшета на базе этой системы с подобными возможностями — предпросмотром в HDR, а также записью фото и видео в HDR. Все это будет возможно на устройствах, основанных на Tegra 4, и такой поддержки ранее нигде не было.

Нужна ли какая-то специальная программная поддержка со стороны приложений? NVIDIA утверждает, что HDR-съемка работает со всем существующим ПО «прозрачно», что никаких программных модификаций не требуется и даже родное приложение камеры в Android прекрасно работает в таком режиме. Пользователь просто выбирает в настройках устройства, включить HDR для всех приложений или нет.

Расширенный динамический диапазон — это лишь один из методов вычислительной фотографии. В будущем будут возможны и другие применения, в том числе: HDR-панорамы, 3D-реконструкция (создание объемного изображения из нескольких 2D-снимков), стробоскопия, отслеживание объектов в камере (для точной автофокусировки, например) и т. д. Вся обработка будет делаться процессором телефона или планшета за доли секунды. Вычислительная фотография — это очень перспективная область, и то, что многие компании обратили на нее внимание, весьма радует.

Портативная игровая консоль Shield

Наверное, можно было бы долго ждать анонса первых устройств на Tegra 4 — ведь NVIDIA хоть и работает с другими компаниями над внедрением нового чипа в будущие устройства, но они не могут ничего сообщить заранее из-за договора о неразглашении информации. Видимо, поэтому в калифорнийской компании решили сделать собственное мобильное устройство на базе нового чипа. И с учетом того, что компания специализируется на 3D-графике и делает мощнейшие SoC, они решили выпустить не просто очередной смартфон или планшет, а портативную игровую консоль.

Проект игровой консоли получил название Shield (забавно, что президент NVIDIA на презентации оговорился, назвав его Project Thor). Это первое устройство на базе системы-на-чипе NVIDIA Tegra 4, и физически оно похоже на игровой контроллер (joypad) со встроенным откидывающимся экраном и чуть большее по размеру, чем контроллер Xbox 360, но при этом заметно меньше Nintendo Wii U.

Кроме понятно какой системы-на-чипе, имеющей в своем составе четыре ядра CPU и мощную GPU-часть, с аппаратной точки зрения игровая консоль NVIDIA отличается откидным 5-дюймовым дисплеем с разрешением 1280×720 с сенсорной панелью и поддержкой множественных касаний. Заявлена технология Direct Touch, обеспечивающая улучшенную отзывчивость сенсорной панели. А вот по поводу типа дисплея (OLED, IPS/PLS, TN и т. д.) пока что ничего не было сказано, хотя по теоретическим параметрам, вроде плотности пикселей (294 dpi), экран выглядит неплохо.

Так как это игровое устройство, то важнее всего в нем — органы управления. И тут все в полном порядке: внешне это обычный современный консольный контроллер с двумя аналоговыми джойстиками, четырьмя «бамперами» и крестовиной d-pad. Впрочем, хотя на вид все очень правильно и удобно, дело это субъективное, и нужно пробовать лично. А вот что точно хорошо — так это наличие всех необходимых стандартных интерфейсов: Micro-HDMI (поддерживающий вывод изображения в разрешении до 3840×2160!), Micro-USB, слот для карт памяти microSD и стандартный аудиовыход 3,5 мм на наушники.

Как и во всех Android-устройствах, память консоли разделена на внутреннюю и внешнюю. Объем внутренней пока что неизвестен, а внешняя память расширяется при помощи карт microSD. Естественно, что консоль NVIDIA поддерживает беспроводное соединение по интерфейсу Wi-Fi 802.11n. Поддерживается также стандарт беспроводной передачи изображения Miracast, утвержденный в сентябре прошлого года: он позволяет передавать по сети Wi-Fi видеоданные в формате 1080p с 5.1-канальным звуком в форматах LPCM, AAC и AC3.

Одним из любопытных отличительных моментов устройства является встроенная аудиосистема. По словам NVIDIA, Shield является одним из первых (или вообще первым) мобильных устройств с использованием фазоинвертора — специального отверстия в корпусе акустической системы, которое обеспечивает расширение низкочастотного диапазона. Встроенной аудиосистемой обеспечивается высокое отношение сигнал-шум (signal-to-noise ratio — SNR) по сравнению с другими портативными устройствами. Для примера, у аудиосистемы iPhone 5 параметр SNR равен 66 дБ, а у Shield — 79 дБ (все данные — NVIDIA), что на уровне компактных бумбоксов.

Так как это мобильное устройство, и тем более игровое, то важнейшим параметром является емкость установленных батарей. И тут NVIDIA смогла приятно удивить: в Project Shield установлена очень емкая батарея 38 Вт·ч, что ближе всего к емкости батарей iPad третьего и четвертого поколений (42,5 Вт·ч), которые считаются рекордсменами в этой области. Батарея Shield должна обеспечить устройству 5—10 часов автономной работы в игровом режиме (10 — для простеньких игр вроде Angry Birds, вероятно) или до 24 часов проигрывания видео высокого разрешения. Что ж, очень неплохо!

А что у консоли с программной частью? Она работает на обычном Android 4.x, нет никаких специальных оболочек, изменяющих облик системы, нет вообще никаких изменений, которые так любят другие производители. Единственное, что отличает консоль от смартфона и планшета в этом смысле — специальное приложение, запускающееся по нажатию большой кнопки с логотипом NVIDIA в центре устройства. При ее нажатии консоль переходит в режим Shield, а повторное нажатие переводит систему в обычный Android — простое и удобное решение.

Соответственно, консоль умеет все то, на что способен Android-смартфон или планшет сопоставимого класса. В режиме Shield есть три раздела: Games, TegraZone и PC. В первый входят игры, установленные на устройство и оптимизированные для Shield, второй — это магазин TegraZone, в котором эти игры можно приобрести, ну а к третьему мы еще вернемся.

Для Shield и Tegra 4 уже оптимизировано 12 игр (см. список в разделе игрового применения), и все будущие приложения для TegraZone также будут разрабатываться с учетом консоли NVIDIA. На презентации показывали несколько игр, в том числе и многопользовательское сражение в Hawken — битву гигантских роботов, основанную на движке Unreal Engine 3.0.

Но 3D-игр для Android не так уж много, тем более оптимизированных для Shield, а NVIDIA не была бы компанией, выпускающей мощные игровые GPU, предназначенные для настольных ПК, если бы не попыталась объединить возможности портативной консоли на Android и ПК с GeForce внутри. Для этого и служит третий раздел в приложении Shield, названный «PC». Он позволяет играть не только в игры из TegraZone или Google Play, но и в игры, установленные в Steam на настольном ПК пользователя, при помощи портативной консоли. Бывает ведь, что не хочется отрываться от игрового процесса, вставая из-за компьютера (сходить на кухню или еще куда-нибудь), и в таком случае можно взять консоль NVIDIA и продолжить игру там, где приспичило.

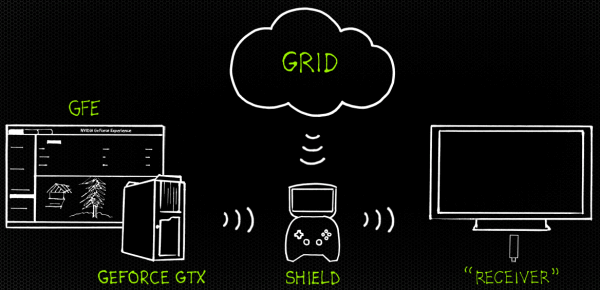

В общем, у NVIDIA получилось нечто вроде домашнего «облачного» игрового сервиса с блэкджеком и…, когда кадр рендерится на большом ПК, стоящем где-то в углу или вообще в бытовом помещении: специальное программное обеспечение в составе GeForce Experience отрисовывает картинку на настольном GPU и передает ее по беспроводному Wi-Fi-соединению на экран устройства отображения и на Shield одновременно. А консоль NVIDIA в данном случае служит просто беспроводным игровым контроллером, команды от которого по Wi-Fi передаются на ПК.

Для такого беспроводного управления и вывода изображения ПК-игр из Steam на внешний дисплей и экран Shield будет нужен ПК с любым GeForce GTX шестой серии начиная от GTX 650 или GTX 660M, процессором не хуже Intel Core i5, объемом ОЗУ от 4 ГБ, а также с поддержкой Wi-Fi 802.11n. А для телевизора или дисплея будет необходим беспроводной ресивер, позволяющий принять изображение по Wi-Fi и вывести его на экран. К слову, показанные в ходе демонстрации игры использовали разрешения 720p и 1080p.

Похоже, что в NVIDIA придумали интересный ход в ответ на то, что их GPU, по слухам, не будут применяться ни в «больших» консолях, ни в карманных — они просто взяли и сделали собственное портативное устройство. Их GeForce есть в большой части игровых ПК, в облачных игровых сервисах у них сильные позиции — так почему не попробовать силы в портативных игровых устройствах? Хотя надо сказать, что выпуск собственной карманной консоли — это довольно рискованный ход с учетом жесточайшей конкуренции на этом рынке, которая только усилится в ближайшее время. Наверное, в том числе поэтому обстановка вокруг проекта была настолько секретной, что в прессу ничего не «утекло» до официальной презентации.

С другой стороны, именно NVIDIA имеет опыт в проектировании CPU, GPU, SoC, а также имеет крепкие связи с игровыми разработчиками и готовое средство по распространению контента — TegraZone. Так что кому же пробовать сделать портативную консоль, как не им? А может, они просто хотели показать другим компаниям, что на базе их чипов можно делать не только планшеты. И все же, конкуренция среди карманных консолей точно будет суровой, и мы еще посмотрим, что из этой затеи в итоге выйдет.

А теперь — о главном. Ожидается, что свежеанонсированное устройство выйдет на рынок во втором квартале этого года, по крайней мере в Северной Америке. Ценовая политика NVIDIA в отношении игровой консоли пока что неизвестна, но обещается, что цена будет сравнима с ценами соответствующих решений (смартфонов и планшетов) конкурентов.

Выводы

Похоже, что у компании NVIDIA в очередной раз получилось одна из наиболее мощных систем-на-чипе для мобильных устройств, как это было ранее с Tegra второго и третьего поколений. Tegra 4 отличается очень мощными CPU- и GPU-ядрами, а также поддержкой всей необходимой функциональности на современном уровне. Это первое в мире решение на основе четырех ядер Cortex-A15, да еще с дополнительным пятым ядром для улучшения его энергоэффективности. Кроме того, можно выделить мощное графическое ядро, состоящее из 72 потоковых процессоров, которое в несколько раз быстрее, чем у Tegra 3.

На играх будущего из TegraZone все это скажется положительно. Четыре мощных CPU-ядра и многократно усиленное графическое ядро позволят использовать в будущих приложениях более сложные вычисления. К примеру, в играх усложнится геометрия и пиксельные расчеты, можно будет применять продвинутые физические эффекты, более сложный искусственный интеллект и т. д.

Кроме этого, очень приятно, что инженеры NVIDIA устранили некоторые из недостатков предыдущего поколения: Tegra четвертого поколения поддерживает двухканальный доступ к памяти, что должно избавить от одного из вероятных узких мест предшественника. И при всех улучшениях энергетическая эффективность, по словам компании, была только улучшена — новый чип потребляет меньше энергии, чем Tegra 3, даже с учетом значительно возросшей мощности.

Предварительные тесты NVIDIA говорят о высокой производительности и эффективности нового чипа, но нужно дождаться более подробных тестов, а еще лучше — готовых решений на Tegra 4 и сравнить их с лучшими из конкурентов в условиях нашей лаборатории.

Новая система-на-чипе NVIDIA интересна не только своей мощью, но и новыми возможностями. Так, в состав двухчипового решения входит модемная часть Icera i500 с поддержкой всех современных стандартов LTE-сетей по всему миру. Очень любопытна и так называемая вычислительная фотография, позволяющая расширить область применения встроенных в мобильные устройства камер и улучшить качество получаемых фотографий и видеороликов.

Не обошлось и без некоторых недостатков. Больше всего нас удивило то, что графическое ядро в Tegra 4 по своим возможностям недалеко ушло от предыдущих мобильных GPU компании. А ведь этой архитектуре уже много лет! Да, 72-ядерный GeForce является достаточно мощным для мобильных устройств, и его возможностей вполне хватает, но не более того. В случае компании NVIDIA, признанного лидера на рынке настольных GPU, от нее и в мобильном секторе всегда ожидается если не в разы лучшее по всем статьям решение, то не уступающее ни по одному из параметров своим конкурентам.

На деле же GPU в Tegra 4 и не рекордсмен по производительности (видеоядро Apple A6X явно быстрее, да и выходящие вскоре на рынок топовые решения других производителей тоже) и по функциональности уступает лучшим представителям мобильной графики. То есть это лишь одно из лидирующих решений, но все же не самое лучшее.

Еще одним из недостатков Tegra 4 можно считать необходимость применения второго чипа для поддержки передачи данных по мобильным сетям, в то время как Qualcomm и Broadcom анонсировали четырехъядерные SoC со встроенными LTE-модулями, которые скоро появятся на рынке. NVIDIA считает, что это не является весомым преимуществом последних, приводя в противовес достоинства своих чипов, отмеченные выше. Но на самом деле однокристальная система со встроенным LTE все же выгоднее и для производителей, и для пользователей, и это преимущество сказывается на самом важном параметре — стоимости решения.

Но все это лишь небольшие недостатки одной из лучших на рынке SoC. Пусть Tegra 4 немного опоздала с выходом на рынок относительно планов компании, но это не сильно повлияло на ее конкурентоспособность, так как задержки с выходом на рынок сейчас случаются практически у всех. Что касается конкуренции с основными производителями смартфонов, вроде Samsung и Apple, то NVIDIA видит свой шанс не только в захвате доли рынка, не охваченной гигантами, но и в менее дорогих моделях, предназначенных для развивающихся рынков, вроде Китая. Естественно, что это будет не Tegra 4, но Tegra 3 или будущие решения, специально ориентированные на смартфоны среднего уровня (хотя там сильна конкуренция со стороны той же MediaTek, так что жизнь легкой не будет в любом случае).

Ну а на рынке мобильных систем-на-чипах, предназначенных для планшетов, дела NVIDIA идут совсем неплохо, судя по исследованиям компаний, специализирующихся на анализе рынков. Так, по данным из отчета Strategy Analytics следует, что в третьем квартале 2012 года NVIDIA серьезно укрепила позиции в группе Android-планшетов (с Apple iPad пока что никто сравниться не может), заняв треть этого сектора и 17% общего рынка планшетов. И действительно, конкурировать с Apple не получится, но тот же Google Nexus 7 показал, что на рынке есть место и для других игроков. Также есть надежда на расширение продаж Microsoft Surface и его аналогов других производителей. Автор вышеупомянутого отчета делает вывод о том, что у NVIDIA есть все шансы усилить свое положение в следующие несколько кварталов, и мы с ним в этом согласны. Tegra 4 вполне способна завоевать еще больший кусок рынка и получить еще более широкое применение в мобильных устройствах. Чип четвертого поколения должен усилить позиции компании на одном из самых лакомых рынков.

К сожалению, подробных технических деталей, которые были бы интересны нашим читателям, NVIDIA на своем мероприятии не раскрыла. Например, мы достоверно не знаем обо всех изменениях в GPU по сравнению с Tegra 3, не получили информации о поддержке USB 3.0 и т. д. Не была объявлена и линейка моделей — конкретных SoC, предназначенных для смартфонов, планшетов и игровых устройств. Мы знаем только то, что в максимальной конфигурации чип включает 4+1 ядро Cortex-A15, работающих аналогично Tegra 3, а GPU-часть состоит из 72 ядер некоей обновленной архитектуры. Вполне вероятно, что NVIDIA решила не раскрывать все карты сразу и припасти часть информации на будущее. Ведь совсем скоро состоится Mobile World Congress 2013 в Барселоне, на котором тоже хорошо бы что-то показать и рассказать. При появлении более подробной технической информации мы обязательно дополним этот материал или выпустим полноценный обзор NVIDIA Tegra 4.